Những chữ cái trong tên CPU Intel Core i có ý nghĩa gì?

Trên các CPU, đặc biệt là dòng Core-i của Intel, chúng ta sẽ rất dễ bắt gặp những ký tự đuôi như K, M, F, H, X… Vậy, ý nghĩa của chúng là gì?

Tin đọc nhiều

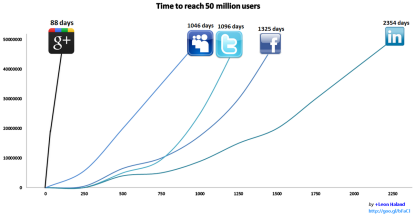

Thiết kế một hệ thống cho 1, 2 người dùng, chạy trên máy local vô cùng đơn giản. Tuy nhiên, một bài toán dễ đến mấy, khi scope lên đến tầm hàng triệu người dùng cũng sẽ trở thành một bài toán lớn và khó hơn rất nhiều lần.

Tại sao vậy? Lấy ví dụ nhé, một con server cùi có thể chịu được 100 request mỗi giây. Khi lượng request lên đến 10000 thì có thể nâng cấp server xịn hơn. Nhưng khi lượng request lên đến 1-2 triệu thì không thể nâng cấp server được nữa, mà phải thiết kế sao cho nhiều server chạy cùng lúc.

Hoặc đơn thuần như việc sắp xếp dữ liệu, với 1000 entry thì chạy trong nháy mắt, nhưng với chục triệu, trăm triệu entry thì có thể chạy đến hàng tiếng, lúc này ta phải lựa chọn thuật giải tối ưu. Vấn đề này liên quan tới scalability (khả năng mở rộng của hệ thống).

Mặt khác, không phải developer nào cũng có cơ hội để giải quyết bài toán scalability. Với các ứng dụng nhỏ,những dự án outsource, ít người đôi khi chỉ cần dùng một số giải pháp đơn giản là đã giải quyết được.

Ở các công ty lớn như Facebook, Uber, Google, đây là bài toán bắt buốc phải giải. Ở Việt Nam chắc sẽ có một số công ty lớn như Zalo, Lozi, Tiki, Thế Giới Di Động mới cần giải quyết vấn đề scalability này.

Khi thiết kế một hệ thống phục vụ hàng triệu người dùng, ta cần để ý 3 yếu tố quan trọng nhất: Performance, Availability, và Scalability:

Rất khó để đảm bảo 3 yếu tố này! May thay, đây là bài toàn đã được hàng chục công ty lớn giải, do đó chúng ta có một số phương pháp, thiết kế sẵn có để giải quyết vấn đề này!

Những kĩ thuật mình nhắc đến trong bài chỉ mang tính chất “cưỡi ngựa xem hoa” (Vậy mà đã gần 2k chữ). Nói thì có vẻ đơn giản, nhưng nếu đi sâu vào một trong các kĩ thuật (load balancer, master/slave, sharding) cũng sẽ mất vài nghìn chữ. Do vậy, mình chỉ liệt kê sơ để bạn đọc có hướng để tìm hiểu thêm.

Mặc dù có thể cả đời bạn không cần dùng đến nhưng kĩ năng này (suốt ngày làm web tin tức, web bán hàng, dự án nội bộ công ty), hãy thử tìm hiểu sâu về chúng nhé! Chúng sẽ tăng cường khả năng tư duy và tầm nhìn hệ thống của bạn lên rất nhiều đấy!

Nguồn: https://toidicodedao.com/2017/08/01/thiet-ke-he-thong-trieu-nguoi-dung-high-scalability/

Trên các CPU, đặc biệt là dòng Core-i của Intel, chúng ta sẽ rất dễ bắt gặp những ký tự đuôi như K, M, F, H, X… Vậy, ý nghĩa của chúng là gì?

Hôm nay mình có dịp ngồi check lại và muốn nâng cấp cấu hình máy tính. Mình muốn mua một con cpu phù hợp với main của mình đang xài. Bởi vậy mình đọc được nhiều bài viết hữu ích. Nên muốn chia sẻ cho các bạn giống mình. Cùng đón xem nhé.

Hôm nay mình chợt nhận ra ổ cứng của mình hiện lên màu đỏ báo hiệu sắp đầy. Nên mình có lên mạng và tìm hiểu cách dọn dẹp ổ cứng và thấy rất hiệu quả tăng được thêm 5gb bộ nhớ. Mọi người cùng theo dõi nhé

Chắc hẳn khi nhắc tới từ icloud server nhiều người nghe sẽ rất quen tai nhưng để hiểu rõ chi tiết và sự khác nhau giữa cloud server và server vậy lý chúng ta sẽ cùng tìm hiểu trong bài viết này nhé.

Hôm nay tình cờ mình làm cho khách hàng liên quan tới phần này nên tiện viết bài chia sẻ luôn về việc cấu hình này. Mọi người theo dõi nhé.

Nếu như bạn đang là một doanh nghiệp với quy mô ở mức vừa và nhỏ, bạn muốn tạo được sự tin cậy và uy tín hơn trong hoạt động gửi email cho khách hàng. Bạn nên suy nghĩ sử dụng email doanh nghiệp theo tên miền riêng. Nếu bạn đầu tư cả một hệ thống Server chuyên nghiệp thì chi phí rất lơn, nhưng bạn không cần lo lắng, trong bài viết sau tôi xin giới thiệu với bạn về cách để tạo email doanh nghiệp miễn phí theo tên miền trên Google.

Nghề nghiệp là một công cụ để mang lại giá trị cho con người. Thông qua việc hoạt động lao động để tạo ra của cải vật chất trong xã hội. Chính vì vậy, làm gì và tương lai nghề nghiệp đó như thế nào là một trong những vấn đề mà rất nhiều người quan tâm. Xu hướng nghề nghiệp trong tương lai sẽ như thế nào để bạn bắt đầu từ bây giờ. Hãy cùng tìm hiểu trong bài viết sau nhé.